- +1

AI社会学|至此,一个算法客观的时代过去了

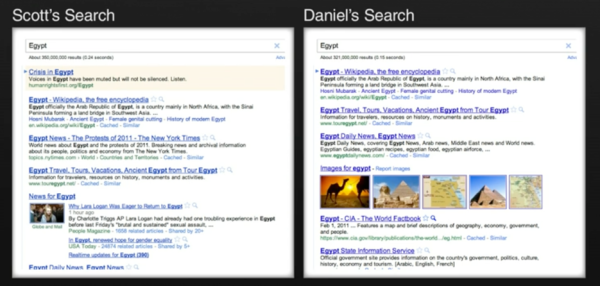

十年前,网红伊莱·帕里泽(Eli Fariser)请他居住在纽约的朋友斯考特(Scott)和丹尼尔(Daniel)分别打开自己的谷歌首页,搜索“埃及”这个地名。彼时,埃及正爆发1977年以来最大的民众示威,要求总统穆巴拉克下台。帕里泽惊奇地发现,同为居住在曼哈顿的白人男性,谷歌对斯考特和丹尼尔所展现的搜索结果截然不同:斯考特的结果里满是有关“埃及革命”的实时新闻,风起云涌,硝烟四起;丹尼尔的首页里则是埃及的骆驼、金字塔、夕阳晚景,一片岁月静好。

图片来源:Eli Fariser: Beware Online Filter Bubble, TED talk, 2011

斯考特和丹尼尔的经历并非独有。事实上,为了使用户更长时间地停留在平台之上,近十年来互联网内容分发平台的“推荐算法” (recommendation algorithms)愈演愈烈,各大网络公司为了迎合用户喜好,往往会基于过往行为数据,选择性地推荐每个用户最感兴趣的内容。帕里泽用了一个形象的比喻来说明现代网络经过算法设置之后展现在我们面前的图景:“过滤气泡” (The Filter Bubble)——在网络高度发达的今天,每一个人都生活在一个私人的、经由算法过滤的信息气泡里。

譬如,谷歌的个性化搜索服务无时无刻不在根据多达57个的变量(包括地址、网址,浏览器种类等等)来为用户们定制他们专属的搜索结果—— 斯考特和丹尼尔截然不同的搜索结果就是个性化算法的产物。脸书的信息流(news feed)则同样精确地为用户们推送算法认为“你此刻最感兴趣”的社交信息——比如, 政治倾向偏左的帕里泽就发现他很少能见到保守派朋友的脸书分享。

我国头条派的兴起则将这一内容推荐算法推演到了另一个极致。你喜欢花花草草,我就给你更多的花花草草;你喜欢内涵段子,我就给你更多的内涵段子。头条大佬张一鸣如是说—— “媒体是要有价值观的,它要教育人、输出主张,这个我们不提倡。因为我们不是媒体,我们更关注信息的吞吐量和信息的多元”。

“算法没有价值观”—— 只如实反映用户个人的好恶。近十年来,算法的“客观中立性”几乎是所有互联网内容分发平台面对监管和社会批评的尚方宝剑。即使面对2016年美国大选的风起云涌、各种干涉选举、传播虚假信息的指控,脸书大佬马克ᐧ扎克伯格仍敢对媒体嘴硬道:“我们是科技公司,不是传媒公司,我们不对平台上出现的内容负责”。科技只是一种工具, 而工具是无辜的。

这就像人和枪的比喻。一个人拿枪杀了人,你能怪枪吗?

扎克伯格也许不读科技社会学。他不知道类似的比喻已经是科技社会学里重复了一千遍的老梗。法国哲学家布鲁ᐧ诺拉图(Bruno Latour)就曾以此来说明人和科技之间的互动关系。一个人拿一把枪杀了人,那么是“枪杀人”,还是“人杀人”呢?学界曾为此争论不休。技术中立派如扎克伯格会支持后者——枪只是工具,人才是真凶 ——科技本身不会作恶。拉图则说,这是错误的。他认为,枪并非一种客观的物体,而是在与持枪者的互动中将杀人这件事实现的。当一个人手上有一把枪,并用它来杀人时,这个人才变成“凶手”,这把枪也同时变成了“凶器”。在这个过程中,枪械和人是在互相改变的。“杀人”这一行为,既不只是一个人杀人意图的结果,也不只是一把枪开火的结果,而是两者联结成的行动网络的共同结果。

从这个角度来说,Technology is not a tool but a set of relations——技术并不仅仅是工具,而是一系列“关系”的集合。因此,也从来没有过客观中立和无价值观的科技,科技在与社会关系的互动中生成进化,也永远背负当时当地社会关系的烙印。

事实上,早在2014年,面对算法对人类知识文化的全方位殖民,康奈尔大学的传播学者塔勒顿·吉莱斯皮(Tarleton Gillespie)就曾对算法的客观性提出系统性的质疑。在这篇名为“算法的相关性”(The Relevance of Algorithms)的短文里,吉莱斯皮梳理了“公共算法” (public relevance algorithms)在现代信息生态系统里的六大面向,每一种都可能对政治产生毁灭性的影响。

其中至关重要的一点,是“算法自诩的客观性” ——相较于人类编辑可能存在的情感、政治和社会的喜好和偏见,算法被平台们许诺为“客观”和“中立”的。因此,当内容分发平台全面使用算法接管之前由人类编辑负责的部分时,所有曾经用来约束信息分发的道德、法律、社会契约被自动架空了。诚实、客观、公正、可靠……这些西方新闻业在上个世纪前期经由一系列社会运动与自我反思与大众达成的(短暂且不完美)共识变成了虚无缥缈的空中楼阁。毕竟,我们怎么能要求一堆冰冷的计算机程序“诚实、客观、公正、可靠”呢?

在帕里泽看来,号称客观中立的算法恰恰是最危险的。他在这本出版于2011年的畅销书《过滤气泡》里(《The filter bubble: How the new personalized web is changing what we read and how we think》 )细梳理了“算法滤泡” 带给现代社会的四大问题:

第一,推荐算法为你推送的是根据你的个人喜好和点击习惯而精心调整的“个性化信息”—— 作为用户,你失去了与其他信息接触的渠道。随着互联网平台逐步垄断现代信息社会的入口,你的信息世界会越来越狭隘和偏颇。

第二,推荐算法同时会调整你的社会关系。譬如,脸书会自动推荐你和意气相投的人和团体互动。和你世界观人生观价值观不同的人群会渐渐从你的社交网络消失,你的社会关系会变得同质化。

第三,推荐算法有侵犯隐私的危险。搜索引擎和社交网络自动收集和分析你的每一次点击和在每一条信息上停留的时间,生成用户画像。他们可能比你妈更了解你,而你将面临无可遁形的危险。

第四,也是最可怕的,在整个过程中,用户没有说“不”的权力。硅谷新贵们相信“用户需求”是可以被制造、被培育出来的。或者,更确切地说,他们觉得自己比用户更了解用户——你说你想读莎士比亚,也许你真正想看的是一千零一遍的《甄嬛传》?正如乔布斯所说:“用户不知道他们想要什么......我们的工作就是告诉用户他们需要什么”(“People don’t know what they want until you show it to them … Our job is to figure out what they’re going to want before they do.” )。

如果帕里泽在2011年提出算法的“过滤气泡”仅仅是在一小批知识界引起反响,那么在十年后的今天,反思内容推荐算法所造成的后果已经成为大半个美国的共识。2016年特朗普意外赢得大选,比任何时刻更让人们震惊于美国社会的撕裂以及号称“客观”和“去价值观”的平台算法对此的推波助澜。有学者指出,由于互联网公司将用户在平台停留时长作为首要KPI,算法常常会被设计成首先推送“博人眼球”的极端化言论。换言之,算法是有价值观的,此时此地,它的价值观是平台利润。谷歌、脸书、推特因此相继成为美国国会听证会的常客。连奈飞(Netflix)也乘热打铁地推出对社交网络进行系统性批判的爆款短片《The Social Dilemma》。

公共政策学者更是明确指出:内容分发平台自诩为“科技公司”而非“传媒机构”一方面是在取悦科技投资者,另一方面则是在逃避监管。学者们认为,平台们用来逃避“传媒机构”定义的几大借口统统都站不住脚。比如,平台们号称自己不生产内容,因而不是传媒公司;而历史上大批传媒公司同时兼顾内容生产和内容分发,更别提脸书和谷歌日渐将各大内容生产平台收入囊中了。

再比如,平台们号称自己不使用“人类编辑”,因而不属于“传媒”之列,可平台算法和用户合作分发内容的机制在传统的媒体机构里也屡见不鲜,而脸书等也仍旧雇佣大批人类合同工来定期清理其社交平台的违禁信息。

当然,更重要的是,内容分发平台(如谷歌、脸书)的收入绝大部分来自于广告 —— 而这是传媒机构一个标志性的特色。

十年前,脸书大佬扎克伯格面对已然过气的传统媒体不屑一顾, 一派硅谷新贵教育前浪们的自信满满:“对用户来说,一只死在前院的松鼠也许比此刻非洲的战火连天更为重要” (A squirrel dying in front of your house may be more relevant to your interests right now than people dying in Africa)。

十年后,面对干预大选、传播虚假信息,分裂社会的指控,扎克伯格在国会面前吞吞吐吐。“我们对用户在脸书上分享的内容负有责任吗?”此刻的他也不得不承认:“我相信这个问题的答案是:是的。”。

另一位推特大佬杰克‧多尔西(Jack Dorsey)则与时俱进。2020年,推特全面修改内容管理条例,最显眼的转变是它在特朗普几乎每一句质疑选票的推特下都打上“此条可能与正式消息不符”的钢印。

另一边,面对内涵段子引发的争议,张一鸣也不得不重新修改自己对算法的定义 —— “产品走错了路,出现了与社会主义核心价值观不符的内容,没有贯彻好舆论导向,接受处罚,所有责任在我” 。

也许正如上个世纪初的西方新闻业一样,新的监管准则和道德需求会围绕内容推荐算法持续发酵;新的社会契约也会再次形成。扎克伯格和张一鸣们,相应地,也必须在承担“算法责任”的基础上做出调整。

至此,太平洋两岸,一个算法客观的时代过去了。

-------

参考文献:

【1】Pariser, Eli. (2011). The filter bubble: How the new personalized web is changing what we read and how we think. Penguin, 2011.

【2】《对话张一鸣:世界不是只有你和你的对手》,财经,2016年12月14日

【3】Latour, B. (1994). On Technical Mediation. Common Knowledge. Fall Vol.3, no 2. pp. 32-33.

【4】Gillespie, T. (2014). The relevance of algorithms. Media technologies: Essays on communication, materiality, and society, 167(2014), 167.

【5】Napoli, P., & Caplan, R. (2017). Why media companies insist they're not media companies, why they're wrong, and why it matters. First Monday.

【6】Transcript of Zuckerberg’s appearance before the House committee. https://www.washingtonpost.com/news/the-switch/wp/2018/04/11/transcript-of-zuckerbergs-appearance-before-house-committee/

【7】张一鸣发公开信致歉:永久关停内涵段子,产品走错了路。 https://tech.sina.com.cn/i/2018-04-11/doc-ifyuwqez8677545.shtml

-----

作者沈虹,毕业于美国伊利诺伊大学香槟分校传播学系,现任职于美国卡内基梅隆大学。她用社会学的方法研究新兴科技。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司