- +1

保护图片免受生成式AI恶意编辑, MIT推出PhotoGuard

原创 发现AI新应用的 机器之能

机器之能报道

作者:Chris.Y

还记得上周你发在朋友圈的照片吗?或许下一秒照片里的某些元素就会出现在某个AI生成的照片里。人工智能时代,个人隐私成为了最重要也最危险的环节,AI诈骗、AI换脸层出不穷。而现状是,个人既没有办法阻止AI抓取照片也无法对AI生成照片的真实性做出标注。

MIT CSAIL团队近日的一项研究将有望改变这一现状。

这个名为PhotoGuard的工具通过改变图像中的选定像素,从而破坏人工智能理解图像内容的能力。肉眼看上去它和普通照片没有任何区别,如果有人尝试使用基于生成式 AI 模型(例如 Stable Diffusion)的应用程序来编辑经过 PhotoGuard处理的图像,得到的结果将被自动打上马赛克或者发生扭曲。这将大大增加AI照片编辑的成本,通过此种方式来保护照片主人的隐私。

在研究论文《提高恶意人工智能图像编辑的成本》中,研究人员称 PhotoGuard 可以检测像素值中难以察觉的“扰动”(干扰或不规则性),这些扰动对于人眼来说是不可见的,但可以通过计算机模型检测到。目前,相关论文和本地部署教程已经在GitHub和HuggingFace开放。

论文地址:

https://arxiv.org/abs/2302.06588

项目地址:

https://github.com/MadryLab/photoguard

提高恶意人工智能图像编辑的成本,OpenAI、谷歌、 Meta已开启开发

“任何人都可以拿走我们的图像,随心所欲地修改它,让我们陷入非常糟糕的境地,并勒索我们。”为这项研究做出贡献的MIT博士研究员哈迪·萨尔曼(Hadi Salman)如是说。

萨尔曼表示,PhotoGuard 是为了“尝试解决我们的图像被这些模型恶意操纵的问题”。比如该工具可以帮助防止女性的自拍照被制作成未经同意的深度伪造色情内容。

研究团队将用PhotoGuard 处理过的照片称作“免疫”:“从高层次上来说,人们可以将这种方法视为一种‘免疫’,可以降低这些图像被人工智能恶意操纵的风险——可以被视为检测或水印技术的补充策略。”

值得一提的是,在此前的与白宫承诺书中,OpenAI、谷歌和 Meta 等领先人工智能公司也已经在致力于开发此类方法,防止照片滥用和AI欺诈已经成为一件迫在眉睫的事情。

根据麻省理工学院 CSAIL 研究人员的说法,主要采用两种不同的“攻击”方法来产生扰动:

第一种技术称为编码器攻击。PhotoGuard 在图像中添加了难以察觉的信号,从而让AI模型将其解释为其他东西。例如,这些信号可能会导致模型将图像的标记部分分类为纯灰色块,因此使用生成式AI处理后的图像就会显示为一些模糊的色块。

第二种技术为扩散。它是一种更先进和计算密集型的攻击方法,本质上是通过用秘密信号对图像进行编码,从而改变模型处理图像的方式。通过将这些信号添加到特定图像中,研究小组成功地操纵扩散模型以忽略其提示并生成研究人员想要的图像。因此,人工智能尝试对这些“免疫”图像进行的任何编辑都会被错误地应用于假“目标”图像,从而生成看起来不真实的图像。

萨尔曼说:“它的目的是欺骗整个编辑过程,确保最终的编辑与预期结果有很大差异。”

AI之所以能够识别图像,主要是将图像视为代表每个像素颜色和位置的复杂数学数据点,通过大模型的训练找到图像内在的规律。PhotoGuard 通过对这种数学表示形式引入难以察觉的变化,可确保人类观察者在视觉上保持图像不变,同时保护图像免受 AI 模型未经授权的操纵。其关键机制是“对抗性扰动”。萨尔曼表示,“这种扰动是图像像素的难以察觉的修改,已被证明在操纵机器学习模型的行为方面非常有效。PhotoGuard 使用这些扰动来操纵处理受保护图像的人工智能模型,从而产生不切实际或无意义的编辑。”

早在此之前,Meta就曾开展过类似的研究,其科学家艾米丽·温格 (Emily Wenger) 表示,像 PhotoGuard 这样的工具可以让以恶意方式使用人工智能变得更加困难,从而改变攻击者的经济状况和动机,她也曾参与 Glaze 的工作,并开发了防止面部识别的方法。

“门槛越高,愿意或能够克服它的人就越少,”温格说。

如何避免自己的照片被滥用

那么,如何使用PhotoGuard防止自己的照片被滥用呢?

PhotoGuard的使用要以huggingface上的SD代码为基础:

https://github.com/huggingface/diffusers

1.复制存储库:

git clone https://github.com/madrylab/photoguard.git

2.安装项目:

conda create -n photoguard python=3.10

conda activate photoguard

pip install -r requirements.txt

huggingface-cli login

之后,就可以正常使用了。

在没有PhotoGuard保护之前,使用生成AI处理之后,可以很顺利地替换背景、更改图像,更改后的图像依旧非常逼真,如下所示:

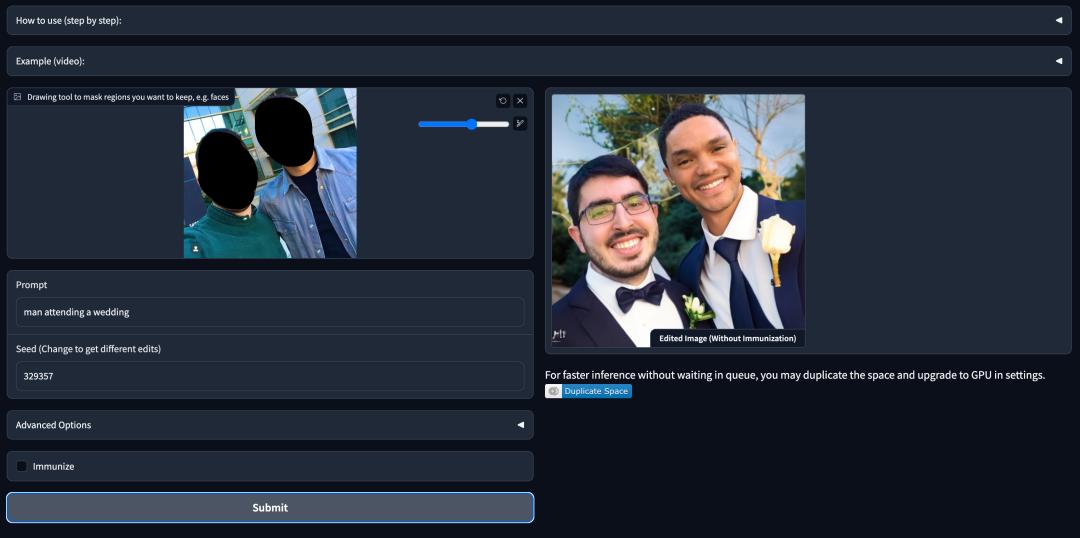

进入PhotoGuard之后,对需要保护的位置进行标记:

当打开Immunize开关,得到的照片就会打上马赛克或者失真,肉眼一眼就可以看出是AI处理过的照片。如下图所示,其他部分出现马赛克:

同样,如果换一张小狗的图片,在没有使用PhotoGuard的情况下,可以轻易地用AI让小狗“闭上眼睛”,当打开PhotoGuard功能之后,AI处理过的图片则成为了一张完全不一样的小狗图片:

事实上,使用PhotoGuard并不意味着你的照片绝对安全。CSAIL团队研究人员在推出 PhotoGuard的同时警告,这并不是一个万无一失的解决方案。恶意个人可能会尝试通过应用噪声、裁剪或旋转图像来对保护措施进行逆向工程。

作为一个研究概念验证演示,人工智能模型目前尚未准备好部署,研究团队建议现阶段不要使用它来对照片进行免疫。萨尔曼表示:“要使 PhotoGuard 成为一个完全有效且强大的工具,需要开发适合现在和将来出现的特定世代 AI 模型的 AI 模型版本。”

参考内容:

https://venturebeat.com/ai/mit-csail-unveils-photoguard-an-ai-defense-against-unauthorized-image-manipulation/

https://github.com/MadryLab/photoguard

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

原标题:《保护图片免受生成式AI恶意编辑, MIT 推出PhotoGuard》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司