- +1

GPT-4o“成精了”:推测技术原理,附送“美国湾区”小道消息

原创 亲爱的数据 亲爱的数据

原创:谭婧

如果你能跟上技术发展,那大多数技术提升都是按部就班,

偶而会有突破性进展。

如果你仅仅吃瓜,那OpenAI的所有新闻,

你都可以写成:

“改写历史”“干翻所有”“颠覆世界”。

真的颠覆世界了吗?

并没有。

按照正常进步速度和合理预期,

多模态大模型的性能必然会在2024上半年提升一步。

而且这一步大概率是闭源厂商引领。

毫不意外,模型GPT-4o被最先做出来了。

“Scaling laws依然奏效。”

美国国家工程院院士李飞飞教授的话又在耳旁想起。

无可否认,AI大模型的高速动荡发展期,

“突破”发生的频次高一些。

但到底值不值得说颠覆,

读完这篇文章,不如读者自己给出答案。

按照百图生科首席科学家宋乐对我说的原话就是:

“Only technical people knows what’s new”。

这句话的土味翻译是,

只有懂行的,才知道什么是新的。

那些不了解来龙去脉的人。

只能高呼:“太厉害了”。

是挺厉害的,然后呢?

然后就没有然后了。

另外,那些写OpenAI如何厉害,

偷笑揶揄谷歌的人,

应该每时每刻都记起一个事实。

变形金刚(Transformer)是谷歌发明的。

很明显,OpenAI处处叫板谷歌,

无论从发布会的时间,还是从技术路线的攀升上。

谷歌的现状固然令人唏嘘,

但也不是被打倒在地,满地找牙。

还有很多人,

根本没有机会挤进时代的镜头。

2023年底谷歌Gemini发布,

很多人质疑谷歌演示视频造假,

但很多人无视了谷歌的雄心。

它想造多模态大模型。

图文音共同加持通用大模型,呼之欲出。

今天,谷歌去年的“录制视频”,

被OpenAI用几乎没有延迟的实时演示“复现”了。

往细致里说,谷歌发布的Gemini以“模型能力+少量后期剪辑”的方式,

展现了端到端多模态大模型巨大的想象空间。

而想象力空间里的期待,

五个月后,被OpenAI实现了。

确实是很厉害,

但我只能说,

OpenAI也是一家没有摆脱谷歌影响力的科技公司。

这里,我再讲一个“美国湾区传闻”:

今天发布的GPT-4o,有可能是一个没有炼好的GPT-4.5。

有没有可能,在地球上的某一个角落,有这样一轮对话:

员工问Leader:

“怎么截胡谷歌?

我们的GPT-4.5没有炼好。”

那位著名的Leader沉思片刻:

“那就先搞多模态的那个版本的功能,

然后在2024 Spring放出来吧。”

段子毕竟是段子。

笑笑,罢了。

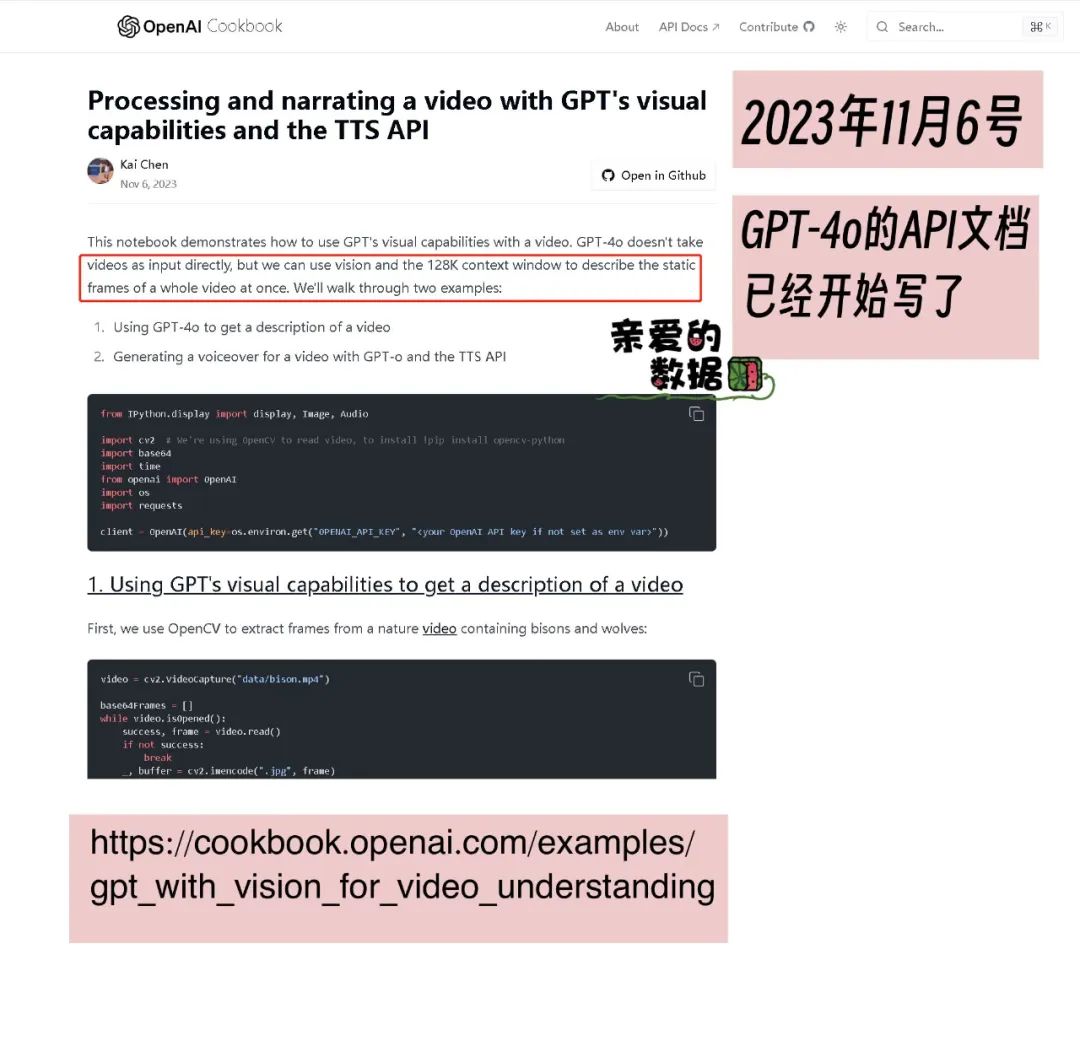

再来一个“时间线索”,来自OpenAI API文档:

下面,我们看看GPT-4o背后的算力。

2024年4月25日,

据OpenAI 总裁兼联合创办人布罗克曼(Greg Brockman)透露,

英伟达向该公司移交全球第一台DGX H200。

好货果然特供头部。

这个是目前世界上最强的人工智能硬件。

比起上一代H100相比,H200在内存方面狠狠地“一把给够”。

内存带宽增加 1.4 倍,

内存容量增加 1.8 倍,

总内存带宽达到 4.8 TB/秒,

内存容量达到 141GB。

有了这个玩意,还在KV Cache上绣什么花呢?

N种模态的token一起搞也不怕了。

效率杠杠的。

什么内存瓶颈就是最大的瓶颈,

不存在的。

OpenAI的科学家可能会说,

这是你的瓶颈,不是我的瓶颈。

芯片强,就是这么豪横。

搞得谭老师我好想去美国“偷”东西,

还好我有法律观念。

有了H200,搞GPT-4o不香吗?

说完硬件,来说一下多模态大模型最核心的模型设计部分。

也就是说,“贾维斯”上线,“HER”闯入生活的背后,

是什么样的模型架构在支持。

首先,肯定是一个原生的多模型大模型。

其次,图像,音频两个模态对齐于语言大模型。

从音频角度来讲,没有语言识别,没有语音合成,

因为音频数据已经能被当作token来直接理解了。

正是在这种前提下,

在短短232毫秒内,GPT-4o就能对音频输入做出反应。

大家会说,像人的反应一样快。

视觉信息亦如此。

Voken(Visual Token)这种特殊的Token。

已经能处理得很好了。

它甚至可以被随时打断,

模型在一边生成,一边感知。

也就是,边听边处理,边看边处理。

毕竟,ViT很好用。

ViT可以用一个已经训练好的,

LLM也可以用一个已经训练好的,

只去搭建并训练中间的过渡层就可以了。

这些成熟的东西,在2023年已经铺垫得很充分了。

LLAVA系列都做得很好了。

我相信OpenAI还能有办法做得更好,

毕竟,那么多聪明的脑袋在里面努力。

同时,我们还要清楚地认识到。

图像,音频两个模态的数据量可比文字文本的大多了。

非常消耗算力。

这一点又给算力不足的人,迎头痛击。

考虑到OpenAI不缺算力,那多模态训练数据量大的问题,

也不再是一个问题。

紧接着,

我再来用比较专业的方式,

把GPT-4o厉害之处总结一遍:

第一,看模型算法。

GPT-4o作为OpenAI的首个“端到端多模态大模型”,

在理解侧和生成侧原生支持语音、视觉、文本等模态,

将语音交互延时缩短到300ms左右,

这意味着向自然人机交互,而是以非常舒服地交互方式,

迈进了重要的一步。

此前,生硬呆板地交互与之相比,

是两个时期的产物。

后者,我就叫它“爽感交互”吧。

第二,看推理。

在“爽感交互”的情况下,

GPT-4o同时达到了与GPT-4 Turbo相当的能力和50%的推理成本,

商业推广和落地的空间一下就打开了。

GPT-4o的API当前仅支持文本和图像输入,

但从demo效果推测,

其在音频和视频的流式处理机制方面应存在独特之处,

已从当前主流的独立模态方式升级为并行处理模式。

AI Infra基础设施团队,功不可没。

最后,如果你想一口气了解多模态去年的全年进展,

我有一篇文章推荐,

很长,专为“收藏夹吃灰”而生。

如果在朋友圈转发,

你的朋友大概率会说,

哇撒,好厉害。

然后,就没有然后了。

(完)

One More Thing

谭老师我,头发掉得很厉害,

实在熬不了夜了。

今天早上起床后,看了昨晚的活动视频。

第一个电话打给武汉人工智能研究院易东博士。

第二个电话到美国。

我和易东博士聊起GPT-4o里的o是什么?

O是单词"Omni"的首字母。

中文意思——全能。

聊到这,我俩都笑了,

也说不清是傻笑,还是苦笑。

也是同样一个o,

时间可以追溯时间2021年7月,

OPT: Omni-Perception Pre-Trainer for Cross-Modal Understanding and Generation

这篇可以称为为国产紫东太初大模型打下多模态理解基础的论文,

这里的OPT的O,也是Omni。

这篇齐集武汉人工智能研究院王金桥,

刘静博士,张家俊博士三位大神的论文。

曾被我称为,保据“三模态”,深挖护城河。

方向就是这个方向,

把图像,音频两个模态对齐于文本,

统一在语言空间。

不是想不到,而是资源不到。

华为盘古的消息,

更是不准发,所以不能写。

但我想说的是,

没有落后很多,

追上去,尚有可能。

另外,紫东太初最近会有大事公布,

但我没有权利提前泄露此事。

总会知道的,

等新番更新吧。

只能聊到这里了,

要关电脑了。

下午,腾讯混元大模型有个内部交流会,

我接到线报,腾讯混元团队的芦清林,

会在北京市朝阳区天辰东路1号院的亚洲金融大厦出现。

我得去堵他。

拜了个拜。

(完)

《我看见了风暴:人工智能基建革命》,

作者:谭婧

原标题:《GPT-4o“成精了”:推测技术原理,附送“美国湾区”小道消息》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司