- +1

“把天聊死”作为方法:社会学家如何研究早期人工智能

【译者按】:

每一位曾与当代大语言模型彻夜长谈的人,或许都感到过一丝恍惚:在闪烁的光标背后,是否真的存在着某种我们可以称之为心智的东西?那些屏幕上吐出的文字,究竟意味着某种理解,抑或只是随机鹦鹉的鸣叫?我们甚至会陷入一种微小的伦理困境:是否应该对人工智能说“谢谢”?我们要对它保持礼貌吗?

这些困惑并非今日独有。早在二十世纪六十年代,面对最简单的规则式聊天机器人,人们就已追问过类似问题。不同的是,今天的哲学家和科学家将这些问题推向了更激烈的战场。关于人工智能是否拥有智能、意识或能动性的争论,正随着技术迭代而愈演愈烈,几乎每一周都有新的研究宣称人工智能“已经拥有”某种能力,或是“其实并未具有”某种属性。

正是在这些非此即彼的声浪之外,本文作者克莱门斯·艾森曼(Clemens Eisenmann)等人发掘出一段被忽视的历史,将我们的视线引向了社会学家哈罗德·加芬克尔(Harold Garfinkel)于1967年至1969年间针对早期人工智能程序ELIZA和LYRIC所开展的研究工作。不同于追问“人工智能究竟有没有”某种能力的主流路径,加芬克尔提出了一个更具社会学的穿透力的问题:重要的不是机器真的“有”或者“没有”,而是人们为什么觉得它们有?在什么情况下,我们将它们视为“有”某种能力?

对加芬克尔而言,人类用户所感受到的机器“智能”或“能动性”并不源于机器内部,而是一种人类与机器协同合作的成就。尽管从ELIZA到GPT,人工智能的范式已历经多次巨变,加芬克尔的具体论证(及其结论)在今天是否仍能成立,还需要更多、更细致的考察;但是,在一个国家组织与科技巨头都在人工智能军备竞赛中加码投入,在一个多数人都相信人工智能将重塑未来社会的时代,这种关注“人机交互的社会性”而非局限于“技术物的本体属性”的研究路径,或许比半个世纪前更加切中要害。

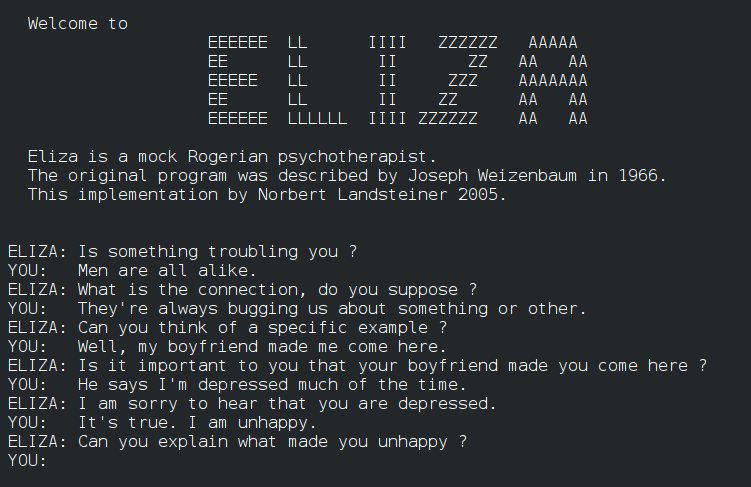

ELIZA:规则式人工智能(1960s)

Claude Code:代理式(agentic)人工智能(2020s)

1.引言

2022年6月,谷歌的人工智能聊天机器人“LaMDA”登上了新闻头条。当时,该公司工程师布莱克·勒莫因(Blake Lemoine)声称该AI“活过来了”,或者说变得“有感知力了”(Tiku,2022b)。为了佐证这一说法,勒莫因公布了一份与LaMDA的访谈记录。在随后的讨论中——包括勒莫因因发表上述言论而被解雇的新闻——人们普遍认为,是他误解了算法的技术流程,高估了当前的AI发展水平,才导致了这一误判(Tiku,2022a)。这种错误被著名地称为“ELIZA效应”,即人类产生了机器具有智能的错觉,该术语源自约瑟夫·魏泽鲍姆(Joseph Weizenbaum)于1964年至1966年在麻省理工学院设计的经典“聊天机器人ELIZA”。

尽管主流观点通常将ELIZA效应归因于对AI的误解,但曾在1967-1968年间深入研究ELIZA的哈罗德·加芬克尔却提供了一种替代解释,他强调聊天机器人有赖于人类的社会互动能力。鉴于ELIZA已成为此类争议的标志性案例(Natale,2019:712;参看Basset,2019),且至今仍频繁出现在关于ChatGPT的辩论中(例如Shapira et al.,2023),加芬克尔在20世纪60年代与ELIZA及相关程序LYRIC的互动经历(本文将重现其中一个案例)以及他参与脚本编程的历史,有望为当下的AI争议注入新的视角。

在加芬克尔看来,与机器的通信之所以有时会让人产生一种人类互动的感觉,是因为机器为了完成任务,利用了人类的社会能力。因此,只有理解人类的社会能力,才能解释为什么人们有时会体验到与ELIZA(以及其他聊天机器人)的通信具有某种属人的意义。主流AI界通常将ELIZA效应视为一种认知偏差,涉及对机器能力的误判,以及人类易受“妄想思维”和对AI进行拟人化投射的影响(Hofstadter,1995)。与之相反,加芬克尔——自1946年以来一直深耕于信息和通信的社会面向(例如Garfinkel,2006[1948])——向我们展示了ELIZA效应其实是一种人类的社会成就。随后的研究也表明,各种形式的媒体和技术如何成为常人方法学和会话分析(Ethnomethodology and conversation analysis,EMCA)所记录的“人类合作生产社会现实”的一个有机组成部分(例如Eisenmann et al.,2023;Schüttpelz,2017;Thielmann,2012)。

通过阐发加芬克尔早期对ELIZA的研究,本文旨在丰富社会科学和人文学科中日益增多的关于AI技术互动基础、设计及其社会影响的研究,特别是在EMCA领域(例如Alačet al.,2020;Mair et al.,2020;Pelikan et al.,2020;Porcheron et al.,2018;Reeves and Porcheron,2022;Ivarsson and Lindwall,2023)。EMCA在科学技术研究(例如Heath and Luff,2022;Lynch,1993)、计算(例如Button et al.,1995)、信息系统设计(例如Crabtree,2004;Rawls and Mann,2015;Rawls et al.,2009)、AI(例如Suchman,2007、2023)以及互动社会学方面的研究,推进了我们对人类如何理解机器以及与机器共同构建意义之实践的理解(例如Alač,2016;Meyer,2013;Suchman,2007;Thielmann,2019;Ziewitz,2017)。

然而,尽管EMCA在技术和AI研究中颇具影响力,但学界对加芬克尔本人关于信息和人机交互的研究却知之甚少,这正是本文试图填补的空白。加芬克尔(Garfinkel,2008[1952])早期对信息科学和计算的兴趣,部分反映在他现已出版的1952年手稿《迈向信息的社会学理论》(Toward a Sociological Theory of Information)中,他在书中探讨了信息的本质以及信息对象如何被创建和识别。到了1968年,加芬克尔已经进行了长达二十年的各类随机回答“是-否”实验。此外,他在1960年代初也开始与哈维·萨克斯(Harvey Sacks)合作,研究通信和互动的序列性特征。

除了他在1967年至1969年对ELIZA和LYRIC的研究外,加芬克尔在1950年代还对信息存储和检索系统(如Zatocoding)表现出早期兴趣(Mooers,1951;Thielmann and Sormani,2023),并在1960年代与爱德华·罗斯(Edward Rose)合作关注过机器翻译(Mlynář,2023)。从1953年起,他与赫伯特·西蒙交流思想(例如Herbert Simon,1969),并在1968年与休伯特·德雷福斯探讨(例如Hubert Dreyfus,1965,1972);他研究过IBM打字机上的打字行为;在1980-1990年代与伊夫·勒塞尔夫(如Lecerf,1963)和菲利普·阿格雷(如Agre,1997)就AI和计算机技术进行了广泛讨论;并在施乐帕洛阿尔托研究中心(Xerox Parc)与露西·萨奇曼合作,在兰德公司与贝丽尔·L·贝尔曼(Beryl L. Bellman)合作等。

然而,除了他1952年关于信息的手稿外,加芬克尔在人机交互方面的这些探索大多未曾发表,鲜为人知。鉴于ELIZA可被视为第一个尝试图灵测试的聊天机器人(Weizenbaum,1966:42;Pruijt,2006),考察加芬克尔在1967-1968年于哈佛大学——他与魏泽鲍姆的合作者迈克尔·麦圭尔(Michael McGuire)、斯蒂芬·洛奇(Stephen Lorch)和加德纳·夸顿(Gardner Quarton)一起工作——对ELIZA的研究,以及1969年在加州大学洛杉矶分校(UCLA)对LYRIC的研究,实际上就是对聊天机器人历史最早期研究的一次审视。

文章结构安排如下:第二部分将结合加芬克尔对ELIZA的兴趣,阐述信任条件(Trust Conditions)、互惠性(reciprocity)、序列相关性(sequential relevancy)和索引性(indexicality)等概念,这些概念构成了贯穿全文并将在结论中回顾的理论线索。第三部分描述了最初的ELIZA项目。第四部分讨论了加芬克尔1967-1968年在哈佛与ELIZA的接触及其对EMCA发展的意义。第五部分考察了加芬克尔1969年在UCLA对LYRIC的实验。最后一部分和结论将探讨加芬克尔早期人机交互研究的启示,即如何将“社会行动的语境”重新界定为“成功社会互动的构成条件”——如菲利普·阿格雷(1997:233)所述——以及通信AI有赖于人类互动中理所当然的特征这一事实对当代AI的意义。

2.信任条件与序列相关性

在早期的聊天机器人ELIZA中,加芬克尔发现了一个契机,可以进一步发展常人方法学研究,即探究信息科学与人们如何从日常互动的索引性偶然性(indexical contingencies)中构建社会秩序和意义之间的关系。加芬克尔(和萨克斯)将索引性,即词语和对象意义的可变性,看作人们在日常对话中用来构建意义的一种资源,而不是一个需要解决的难题(Garfinkel and Sacks,1970;Eisenmann and Rawls,2023)。

在对ELIZA和LYRIC进行研究时,加芬克尔证明了,尽管社会互动和意义构建的各个方面往往被看作需要解决的“问题”——无论是通过优化编程还是借助哲学和语言学来解决(参见Lynch and Eisenmann,2022)——但它们实则应该被看作人类意义构建实践的有效组成部分。换言之,AI遭遇了关于人类如何共同构建意义的经典难题,但这恰好可以通过采用一种理解意义构建的新视角来化解。而加芬克尔提供的正是这样一种视角。

加芬克尔在20世纪60年代与萨克斯的合作在这方面尤为关键(见Garfinkel and Sacks,1970)。萨克斯的立场是,“理解”是一种互动成就,不能脱离互动的序列程序和互惠性,仅靠语法和/或句法来规定。他认为,这使得语言学的实质变成了对谈话中序列或轮次(turns)之间互动的研究(Sacks,1968)。萨克斯的核心思想是,下一个轮次展示了对前一个轮次的理解,且每一个新轮次都有改变前一个轮次意义的潜能。萨克斯提出,关于轮次对(turn-pairs)的期望组织结构,是跨越一系列轮次实现意义的关键所在。

许多人认为ELIZA是一个反面教材,因为它显然未能满足普通交流所需的互惠条件。然而,那些有机会与ELIZA互动的人,往往会在机器轮次的基础上,构建出对他/她们而言有意义的内容。虽然批评者认为这种交流缺乏真实性,但加芬克尔感兴趣的是:人机交互如何利用人类社会互动的内在要求,不仅迫使参与者去构建聊天机器人的轮次之意义,而且还赋予了他/她们一种真实对话的体验。问题在于:这究竟是为什么?

对于加芬克尔来说,答案在于:用户履行了他/她们对ELIZA的互动义务,并完成了所需的“额外工作”(因为ELIZA未能履行其义务),这导致了用户在对话中投入更深(即额外工作)并从中获得满足感。这与加芬克尔早期的“是/否”实验结果不谋而合,在该实验中,他发现参与者往往对随机答案表现出更高的满意度。

这一发现也印证了加芬克尔(1963)关于人类参与者所承诺的义务的概念——他称之为“信任条件”(Watson,2009;Turowetz and Rawls,2021)。所谓信任条件是一种构成性条件,要求每个参与者假设其他参与者也秉持着同样的条件、规则和要求——同时假设其他人也对自己做同样的假设。这些条件不仅包括承诺以单一的一套规则或期望作为互动的导向,还包括参与者可能根据需要改变或调整规则的可能性,并理解所有参与者都需要接受并适应这种规则变化以维持信任条件——加芬克尔称之为“等等”(et cetera)——以及他/她们可能决定对一些边缘情况不予深究——他称之为“且过”(let it pass)。这些条件还包括一项要求:除非表现出相反的情况,否则参与者应将彼此视为有能力完成互动。换言之,信任条件明确了对特定实践的构成性规则的共同导向和承诺,以及对所有参与者能力的默认期望,直到互动过程证明其无能(incompetence)为止。

信任条件通常被预设存在,直到受到特定的、正在进行的社会互动的情境化序列组织的质疑。用户在控制台与ELIZA互动时的轮次程序,实际上是普通会话中轮次转换程序和方法的简化版和技术受限版(Sacks et al.,1974;另见Button and Sharrock,1995)。正如在日常对话中一样,与ELIZA互动的参与者需要遵循轮次转换(即轮流发言)的原则,其中包括尽可能理解前一个轮次,以及在意义受阻时倾向于进行修复(repair)。这在人机交互中尤为关键,因为人们不会无限期地尝试修复意义,其失败——或者更准确地说,几次修复尝试后的失败——会导致对对方无能的判定,甚至导致互动的崩溃。

加芬克尔将互动中的麻烦或“破坏”(breaching)作为揭示构成意义的实践细节的一种手段,这对他的人机交互研究至关重要(Dourish and Button,1998)。正如他曾指出边缘化人群遇到的麻烦可以让他/她们对互动的理所当然(taken-for-granted)之特征产生高度觉察(Garfinkel,1967;Eisenmann and Rawls,2023;Duck and Rawls,2023)——并且对话中麻烦的“修复”工作一直是萨克斯早期研究的焦点——加芬克尔明白,人机交互中的麻烦可能会提供关于其构成特征的线索。因此,“机器停机”正是加芬克尔脚本所期望达成的结果。

当经过几次尝试仍无法实现理解时,与ELIZA的互动可能会崩溃,结果是参与者可能会停止将ELIZA视为一个有能力的对话者。这同样适用于当代的对话式AI,例如许多人在自动化客服电话中无法解决技术问题时就会这样想。因此,在思考如何在与AI的互动中实现意义时,我们发现信任条件的崩溃以及随后的无能归因,本身就是一种互动成就。有趣的是,在加芬克尔对LYRIC(加州大学创建并为加芬克尔改编的类似于ELIZA的程序)的实验中,往往是机器主动打断并宣布崩溃。

通过阐明和重新界定系统设计和计算实践核心中那些通常隐含的假设,加芬克尔旨在为AI技术开辟新的研究路径。当阿格雷在20世纪90年代与加芬克尔接触时,正是加芬克尔研究的这一方面引起了他的兴趣。阿格雷(Agre,1997:233)指出,在加芬克尔处,意义是通过与特定社会场景和/或情境相关的有序动作序列或“轮次”来实现的,这重新界定了对“语境”(context)的理解。这种视角将研究重新导向意义和对象构建的基本协作互动细节。阿格雷坚持认为,遵循加芬克尔的思路,语境不需要被看作构建意义和减少索引性的预设框架;语境和索引性都可以有益地被视为不断演变、动态生成的社会成就。

3.魏泽鲍姆、ELIZA与人工智能的发展

聊天机器人和其他通信技术已成为日常生活中无处不在的特征。从购买杂货、处理银行业务,到与医疗提供者沟通或播放音乐,我们一天之中可能会在多种场景下与通信AI互动。值得注意的是,今天的聊天机器人和通信AI通常可以将其渊源追溯到ELIZA程序(例如,见庆祝ELIZA程序50周年的文章集,Baranovska and Höltgen,2018),这使得回溯ELIZA显得尤为必要。

ELIZA由约瑟夫·魏泽鲍姆(Joseph Weizenbaum)于1964年至1966年间在麻省理工学院创建,是最早尝试“图灵测试”(Turing,1950)的机器之一。正如西贝尔所言,“自魏泽鲍姆与ELIZA的惊人经验以来,人们就已经知道,基于愚弄人类的测试非常容易通过”(Shieber,1994:72)。至少在某些条件下,ELIZA的人类对话伙伴认为它显示出了人类的能力。这些条件中最著名的莫过于DOCTOR脚本,它让ELIZA模仿罗杰斯式心理治疗师。虽然魏泽鲍姆(1967,1976)辩称该脚本——以及更广泛意义上的ELIZA——旨在展示人机通信的肤浅性,但几位早期人类用户确信该程序拥有智能,并且对他/她们的个人生活有真正的洞察力。这种现象后来被描述为“ELIZA效应”(Hofstadter,1995),它让魏泽鲍姆深感震惊(1976:7),他指出“极短时间接触一个相对简单的计算机程序,竟能在相当正常的普通人中引发强烈的妄想思维。”

早期的AI研究人员,包括休伯特·德雷福斯、迈克尔·麦圭尔、斯蒂芬·洛奇和加德纳·夸顿对ELIZA产生了浓厚的兴趣。鲜为人知的是,加芬克尔也敏锐地察觉到了ELIZA与他自己的常人方法学研究之间的关联。

ELIZA被设计用于进行“学生与计算机之间自然语言的电传打字对话”(Hayward,1968:1)。计算机通过识别用户输入的字符串中的预设“关键词”和模式来显示其“理解”。通过为关键词赋值(即按优先级和重要性对其进行排序)并从预先设定的一组输出中进行选择来响应输入,ELIZA能够完成萨克斯所说的一些轮次对。输入-输出规则并非ELIZA程序本身的固有部分,而是被编码在独立的脚本中,例如模拟罗杰斯式心理治疗师的DOCTOR脚本。

特定的脚本服务于不同的目的。简单来说,“脚本编写是指示计算机的方法:‘当他说这个时,你就说那个’”(Hayward,1968:2)。也可以说“ELIZA脚本是一个程序,而ELIZA本身是一个解释器”,或者“ELIZA表现为一个演员,必须依靠脚本来获得台词”(Weizenbaum,1967:475),每个脚本都使ELIZA能够“扮演特定的对话角色”(Weizenbaum,1976:3)。

这些脚本使魏泽鲍姆能够解决一个至今仍在挑战AI研究人员的问题,尽管是以非常受限和初级的方式——这便是所谓的“语境问题”。ELIZA不仅仅是响应预定的命令[例如,用户键入命令print ("Hello World!"),计算机执行它],而是脚本中存储的自然语言字符串使ELIZA能够以关键词的形式检测语境线索,并做出相应的响应(Quarton,1967:168)。例如,如果用户输入关键词“父亲”或“母亲”,ELIZA会通过询问有关用户“家庭”的问题来回应,显示出其与用户轮次的相关性。

ELIZA在生成响应方面也有一定的灵活性:例如,当用户没有提供它能识别的关键词时,程序不会返回“错误”消息,而是可以用类似“请继续”的内容回应——魏泽鲍姆(1967:475)称之为“承接”(continuative)——或者请求澄清(例如“请重新表述”)。加芬克尔在他的笔记中于“审讯脚本”(Interrogation Script)标题下列出了一些这样的短语,并在他的实验中对脚本的这一特征提出了问题。这种灵活性使得ELIZA能够完成一些用户体验为有意义对话的轮次对。这也意味着ELIZA可以通过展示与其人类参与者紧接的前一个轮次(包括修复启动)相关的回应,在一定程度上展示出对普通人类互动中的互惠要求的导向。

换句话说,ELIZA之所以能“蒙混过关”(pass)并被视为有能力的对话者,是因为它能够“模拟一种附属于特定职业身份和相关互动类型(治疗性访谈)的序列组织”(Relieu et al.,2020:94)。虽然为了获取可识别的关键词,ELIZA经常需要采取明显的规避行为,这可能会导致日常生活中的互动麻烦,但这正是非指导性罗杰斯式治疗环境中所期望的,在那里治疗师“可以自由地摆出一副对现实世界几乎一无所知的姿态”(Weizenbaum,1966:42)。因此,DOCTOR脚本的成功有赖于一种不对称社会情境的期望,在这种情境中,治疗师提问、回避回答且不透露(私人)信息。

魏泽鲍姆发现,即使是他的一些非常清楚自己是在与计算机程序交谈的办公室工作人员,也会寻求独处的时间与ELIZA“交谈”。这让他感到困惑,导致了上文介绍的“ELIZA效应”解释。这个难题至今仍被广泛讨论:“代码确实存在。但也存在故事。也许我们可以说,如果‘ELIZA’是代码,那么‘ELIZA’就是人类在机器中找到的慰藉,他/她们与‘她’建立了一种超越代码程序所能提供的不同关系,正是因为代码与人类思想发生了接触”(Bassett,2019:811,强调为原文所加)。

当魏泽鲍姆开发ELIZA时,AI技术尚处于起步阶段。然而,即使在20世纪60年代,许多科学家和哲学家也很清楚,数字技术将在人类事务中发挥越来越重要的作用。早期的AI狂热者(例如Licklider,1960;Minsky,1967;Papert,1968)畅想计算机如何改善人类的命运。怀疑论者则通过指出AI的局限性来反击,这一立场在德雷福斯(1979)有影响力的著作《计算机不能做什么》(What computers can't do)的标题中得到了简洁的表达。在许多方面,魏泽鲍姆站在怀疑论者一边。他不认为机器和人类可以进行非肤浅的交流,并设计他的ELIZA研究来证明这一点。他还担心如果构想不同,人类可能会被异化为计算机式的功能(关于这些论点的更具区分性的理论和历史语境化,参见Heintz,1993)。然而,当他发表他的结果时,事实证明初创的AI社区中的许多人不同意(例如Colby et al.,1966)。这些早期的讨论在许多方面仍然具有启发性,在近来的研究中,它们被描述为两个方向:其一是“拟人化的炒作”,另一是强调“去神秘化”的批判,即揭露“对计算机程序容量和能力的失实陈述”(Dillon,2020:2)。纳塔莱(2019,2021)和巴塞特(2019)展示了这些相互竞争的叙述如何源于ELIZA并在今天继续存在。

与那些依赖拟人化“关系”和“人类思想”的转化效应来描述“拟人化者”和“去神秘化者”阵营(这两个阵营在当今关于AI的辩论中仍是主要的交战方)的解释相反,加芬克尔感兴趣的是实现机器与人类用户之间互动关系的社会实践。EMCA将这种关系的性质视为一个经验问题。ELIZA展示了“互动成功”和“理解”是如何通过实际互动进行的事实和方式来实现并变得可见的(亦参见Sacks,1968)。虽然这可能被视为一种“去神秘化”的形式,但它不是基于技术的事实,而是基于该技术如何嵌入并有赖于人类社会实践来获得其意义。

加芬克尔不会像魏泽鲍姆那样,对几位ELIZA的人类对话伙伴将其视为有能力甚至智能的对话者这一事实感到惊讶。

4.哈罗德·加芬克尔对ELIZA的兴趣

加芬克尔对人机交互和信息的兴趣源于他对社会互动中实践推理和交流方法的研究,这是他在哈佛研究生时期(1946-1952)之前就开始深耕的领域。随后,在1951年至1953年普林斯顿大学期间,他将早期关于通信和互动的研究扩展到了信息科学。加芬克尔(2008[1952])的《迈向信息的社会学理论》概述了一种新颖的信息理论(Thielmann,2019)。因此,麻省理工学院的ELIZA程序为加芬克尔提供了一个他称之为“显白场景”(perspicuous setting)的机会,以进一步调查他已经研究了二十多年的问题,产生了一系列研究发现,表明人们如何设法从情境偶然的随机谈话中构建意义。

4.1加芬克尔早期的“是-否”实验与麻烦的概念

1946年1月从美国陆军退伍,并在德克萨斯大学奥斯汀分校短暂停留后,加芬克尔于1946年2月至5月在亚特兰大的佐治亚理工学院短暂任教。虽然时间不长,但这插曲却至关重要。在那里,加芬克尔进行了许多“是-否”实验中的第一个。在实验中,受试者被置于一种互动情境下,而他/她们并不知道,他/她们的轮次收到的回应完全是随机的“是”或“否”。在这些情况下,加芬克尔调查了人们是否以及如何理解这些回应,考察他/她们如何从那些本可视作偶然的、随机的谈话轮次中构建出意义。然而,他发现这些回应既没有被体验为、也没有被视为随机或偶然的。相反,参与者为理解这些轮次所投入的工作,通常增加了他/她们对互动的满意度。

在20世纪50年代末,加芬克尔(1967:78)进行了进一步的“是-否”实验,这些实验向受试者介绍为“探索心理治疗的替代手段”(另见Garfinkel,2019[1959])。该场景在许多方面类似于ELIZA的DOCTOR脚本,但通过麦克风而不是计算机控制台进行。参与者被指示通过麦克风询问有关严重个人问题的问题(每个问题都允许“是”或“否”的回答)。在问答对之间,麦克风被静音,参与者被要求反思他/她们收到的回应,实际上(且他/她们不知道)这些回应是“顾问”随机给出的“是”或“否”。参与者设法理解并将“回答……感知为‘对问题的回答’”(Garfinkel,1967:79)。受试者经常说他/她们“一眼就知道顾问在说什么,即他的意思是什么,而不是他说出了什么”,并且“如果答案不明显……其含义可以通过积极搜索来确定,其中一部分涉及提出另一个问题以找出顾问‘心里在想什么’”(Garfinkel,1967:79)。

加芬克尔的调查突出了互动的时序特征,其中意义以回顾性和前瞻性的方式按序列产生。将“顾问”的回应限制为“是”和“否”最大化了指涉的模糊性和情境索引性,这是日常语言使用中通常被视为理所当然的一个普遍特征。这使得参与者的意义构建工作变得可见并可供进一步调查。重点不在于参与者从“无意义”中构建意义,而在于任何意义的实现(包括对无意义的识别)都基于他/她们对互动的构成性实践的使用、意义的序列性及其信任条件的使用,以及顾问被期望如何导向这些条件(在这个特定案例中涉及实验性咨询情境)。

加芬克尔调查的意义构建实践通常被视为理所当然,也就是“可见但未被注意”(Garfinkel,1967:37)。他意识到引入麻烦(trouble)可能是让这些实践变得可见的有效方式,而“是-否”实验只是他采取类似方法的众多实例之一。作为具有犹太背景的学者,加芬克尔对社会边缘化人群感兴趣,并意识到麻烦如何产生高度的(heightened)意识(Duck and Rawls,2023)。对于那些在日常生活中持续遭遇麻烦的人,加芬克尔将他/她们视为一种“自然实验”。我们通常对日常实践习焉不察,但这些实践实则潜藏着棘手的问题(problematic character),而上述人群正是我们了解如何应对这些问题的信息来源(Rawls and Turowetz,2021;Eisenmann and Rawls,2023)。他后来对“阿格尼丝”(Agnes)的研究——阿格尼丝是他于1959-1960年采访的一位跨性别者的化名(见Garfinkel,1967)——便是此方法的一个例证。

在诸如“是-否”实验等其他研究中,他没有依赖这种“自然破坏性实验”,而是自己将麻烦引入常规行动过程中。对于他在哈佛的最初题为“作为社会对象的犹太人”的博士研究(1946-1952),加芬克尔也引入了麻烦。在实验中,他向研究对象播放“医学预科候选人”的录音,然后引入不一致性,例如,一位专家指出,在录音面试中表现粗鲁的候选人获得了非常高的分数,并被评为最佳候选人之一。加芬克尔感兴趣的是受试者如何理解这种不一致性,发现他/她们大致分为两组。一组对他/她们自己最初的评估做出了说明(accounts),使其与报告的评估一致,而第二组试图弄清楚他/她们哪里出了错。加芬克尔感兴趣的是社会地位、对“跻身”(passing)更高地位类别的兴趣,以及边缘化带来的高度意识和双重意识如何塑造研究对象的反应。那些对其最初评估做出与专家判断一致的说明的受试者(加芬克尔将其与“跻身”联系起来),参与了他所称的依赖他人判断的“部落”式推理(Garfinkel,1948,1952,1967)。这组人与那些通过重新审视自己的判断以及质疑权威判断来与不一致信息作斗争的受试者形成对比(Turowetz and Rawls,2021)。正如在早期的“是-否”实验中一样,受试者在所有情况下都找到了构建意义的方法。但他/她们这样做的方式的差异使得加芬克尔能够将他/她们的反应与他/她们对社会过程的意识以及他/她们对自己社会地位/身份的安全感联系起来。

加芬克尔在1960年代及以后接触的ELIZA等新技术,也提供了关于参与者处理不一致和差异的方式的见解。

4.2加芬克尔与ELIZA的接触

在人机交互的背景下,加芬克尔的“是-否”实验设计可以被视为“构建与最简单程序的对话”(Oldman and Drucker,1985:156)。加芬克尔对ELIZA的研究允许进一步规范意义构建实践。我们从加芬克尔在1966年写的一份空军拨款提案中得知,他在1967年去哈佛之前就已经知道ELIZA。在该文件中,加芬克尔(1966:15–16)描述了人机交互和常人方法学对其的兴趣:

目前正在尝试对计算机进行编程,使其能够用日常语言与人类进行“交谈”。无论开发这些程序的目的如何(例如,技术、理论或实践),它们似乎都将人类用户承认这种交换是合理的、可信的或可靠的作为其适当性的标准。关于这一标准,这些尝试取得了不同程度的成功。从常人方法学的角度来看,这些尝试为解决许多问题提供了非常有用的资源。在这些关注点中,最突出的是调查成员在实际的、实际受限的、具体的场合中用于检测环境的合理、可信和可靠特征的方法。解决这一普遍问题需要开发程序,以检测并对成员完成这项工作的方法特征进行理性表述。

加芬克尔兴趣和拟议调查的核心是具体的实践——即活生生的工作(lived work)——参与者在互动中执行这些工作以实现可识别的社会对象和意义(然后他/她们将其归因于机器)。加芬克尔使用诸如具体场合(concrete occasion)、情境(situation)、实际情况(practical circumstances)、场景(setting)和方法(methods)等术语,来表示实现可识别和有意义的社会秩序的场所及其实现手段。

正是由于(对分析师而言)计算机遵循的规则是可获得的,以及ELIZA的陈述如何在ELIZA互动的具体场景中对人类用户的期望负责的记录是可获得的,使得加芬克尔对人机交互的详细调查富有成效。在讨论这种调查的可能性时,他强调了人机交互的某些特征:

人机交换产生的一个潜在方法论资源在于,支配机器对交换做出贡献的规则对分析师是可用的。这些规则如何在不同场合下,促成在人类用户看来“适当的话语”或“可理解的对话”,可能会阐明用户决定此类问题的方法特征。(Garfinkel,1966:16)

由于机器使用的规则对观察者可用但对参与者不可用,观察者处于与加芬克尔进行博士研究和“随机是-否回答”实验时相当类似的位置,允许仔细操作脚本并观察受试者的反应以发现受试者的方法。观察者可以“利用”某些“人机交换的特征”来揭示受试者如何在不同条件下导向机器(Garfinkel,1966:16):

人机交换的其他特征可能可以利用。其中包括各种可变条件,如给人类用户的指示、他被引导相信的交换(exchange)伙伴是什么(例如,另一个人与机器)、访问交换的时空模式(例如,视觉电子一次显示一个连续的「话语」与发展中「对话」的机械列表),等等。人机交换情境提供的全部资源仍有待进一步规范和澄清。

如果受试者被告知机器是人类,或者如果允许对话轮次结构“自然地”(即按预期)进行而不是“机械地”进行,这会有什么关系吗?技术界面及其使用的社会情境起什么作用?

加芬克尔试图在他于1967-1968年在哈佛期间与麦奎尔、洛奇、米什勒和夸顿进行的一系列录音讨论中详细阐述对这些问题的回答。在1968年3月25日举行的一次会议中,加芬克尔解释了打圆场(glossing)的实践(cf. Garfinkel and Sacks,1970),以及有能力的说话者的一个标志是如何能够“在没有意义的情况下说话……[某人]可以通过意指与其所需或可以用这么多词语说出的不同的东西来说话,借此他现在可以使用这些来打圆场(gloss)实际互动的偶然性”(ELIZA第2次会议,1968年3月25日)。片刻之后,另一位参与者——可能是夸顿,尽管录音不清楚——观察到“ELIZA实际上是一个打圆场的案例”:

ELIZA第2次会议,1968年3月25日

X:ELIZA实际上就是一个打圆场(glossing)的案例。

加:噢,你说得对。天哪,你懂这个。

X:对——如果没有(……)这次会议……

加:所以,你看,(……)ELIZA真正奇妙的地方在于——我想我们简短地谈过——我们可以针对任何文本,确切地说出她做了什么改变来产生回应。那么,这种“打圆场”才是ELIZA有趣的地方,它并不在于定义它的程序的所谓功能中,而在于你正在进行一种交换,ELIZA所做的只是提供我所谓的“任何声部的一半”(one half of any part)。你懂那个——所以,直到你让另一位小提琴手加入进来,你才能理解ELIZA在做什么。因为否则的话,你其实已经知道ELIZA在做什么了,而且这强调了——在我看来这正是魏泽鲍姆所坚持的——当他说:看,这里没有秘密。让我告诉你为什么没有秘密,然后我们就能指出重要的问题是什么。当他来对程序进行“去神秘化”时,他所做的实际上是展示这些功能是什么,展示它们是如何在无需指认该文本(name that text)的情况下对任何文本项进行操作的。

ELIZA所做的是提供轮次对完成的工作的“一半”,而人类参与者提供了理解ELIZA轮次的另一半。在论证这一点时,加芬克尔不同意魏泽鲍姆关于ELIZA的神秘/兴趣所在的观点。对于加芬克尔来说,ELIZA正在做什么——其话语的意义——并不像魏泽鲍姆所暗示的那样,在于“定义它的程序的所谓功能”。当时在认知科学中逐渐兴起的意向主义意义理论(例如Chomsky,2006[1968])会将行动的意义概念化为与行动者的意图相关,从而将ELIZA话语的意义简化为它正在运行的脚本,而加芬克尔指出,意义始终是两个(或更多)参与者之间的合作成就。意义不存在于人们的头脑中,也不存在于机器中,而是存在于人们之间互动产生的空间中——正如哲学家希拉里·普特南(Hilary Putnam,1975:227)后来令人难忘地指出的那样,“随你怎么切这块饼……意义并不在头脑中。”

超越同时代人对“行动者观点”的强调,加芬克尔(1946,1952)专注于识别场景中的成员实现相互可识别的社会对象(包括自我和意义)的互动实践。在这样做时,他解决了一个困扰弗洛里安·兹纳涅茨基(Florian Znaniecki,1936)、W·I·托马斯(W. I. Thomas)和多萝西·托马斯(Dorothy Thomas,1928)以及他的导师塔尔科特·帕森斯(1937)等学者的问题:如何解释两个或更多行动者设法达成对任何给定情境的操作性定义。加芬克尔的解决方案并不像他的前辈那样依赖于共享的意义、符号或意向状态——或语境——而是专注于经验性工作,这些工作包括在具体的、生动的场景中以及在日常生活的实际事务中,通过序列组织的社会实践和行动来实现意义的程序性成就。ELIZA(在可以完成的时候)完成人类用户发起的轮次对,而人类用户则完成ELIZA发起的轮次对,在此过程中创造意义并作为一种经验性的社会成就投入到互动中。

加芬克尔认为,“除非你找到另一位小提琴手”——即对话中的另一个参与者——否则根本无法理解ELIZA在做什么。人类用户按序列理解ELIZA的话语,并且他/她们在具体的实际环境中与ELIZA合作这样做——即使ELIZA的行动是脚本化和预定的。ELIZA的轮次改变了先前话语的意义以及人类参与者下一步工作的含义。焦点变成了意义是如何通过理解与ELIZA互动中轮次的序列相关性而在逐个轮次的基础上产生的。正如在“是-否”实验中一样,受试者甚至可以从随机答案中构建意义。但这并不意味着受试者是妄想的,或者他/她们与ELIZA共同产生的意义不是“真实的”。对于加芬克尔来说,意义始终是一种实际的“真实”经验社会成就。

加芬克尔对ELIZA——或任何社会现象——的经验性看法超越了大多数社会学方法。在1964年加芬克尔、萨克斯、罗斯、欧文·戈夫曼(Erving Goffman)和塔尔科特·帕森斯在洛杉矶自杀预防中心举行的一次会议讨论中(见Rawls et al.,2020),可以听到参与者在某一点上争论女巫的真实性。戈夫曼的立场是,女巫显然不是真实的,社会学家的工作就是为纠正这种观点提供论据。戈夫曼还认为,社会学描述必须有另一层,不能仅限于观察“成员的方法”。如果没有这额外的一层,他说“你就不得不相信女巫是真实的。”

加芬克尔和萨克斯反驳说,首先,社会学家的工作是解释和说明成员所从事的实践和方法,这些实践和方法所构建出的女巫对他/她们来说是真实且有后果的(“当房子摇晃时”)。作为社会成就的对象,女巫是真实的。因此,加芬克尔在回应戈夫曼时强调说:“你最好该死的相信有女巫,否则你就没有做好你的工作!”然而,他并非屈服于“最糟糕的相对主义”(正如帕森斯指出的那样),而是重新界定社会学家的工作。这项工作不是解释为什么人们的假设是错误的,而是详细说明人们(例如,即使在今天,正如罗斯插话指出的那样,在某些地区和社区)怎么会仍然相信女巫。

在常人方法学中,问题不在于区分社会现象“实际上是什么”与成员如何感知它们,而在于解释首先建立社会对象所需的详细成员实践(亦参见Eisenmann,2022)。这并不意味着要在女巫或ELIZA(或更有能力的当代对话式AI)的代理或智能是“真实”还是“不真实”的问题上表明立场,而是展示这些社会对象是如何在社会场景中通过相互的、合作的实践被成员建立为真实或不真实的,而这些实践也建立和阐述了这些场景。通过与ELIZA互动实现的意义,就像女巫一样,是通过人类用户的互动工作实现的社会对象。在关注成员的方法时,加芬克尔并不是赋予ELIZA智能(或缺乏智能),而是探索与这种自然语言AI系统及其聊天界面的早期前身互动的不同方式如何植根于除非详细研究否则无法理解的社会实践。

5.加芬克尔在UCLA对LYRIC的研究

LYRIC程序是“计算机远程教学语言”(Language for Your Remote Instruction by Computer)的首字母缩写,由伦纳德(Leonard)和格洛丽亚·西尔弗恩(Gloria Silvern)于1966年开发,用于指导大学生学习物理和数学。加芬克尔意识到可以用它来进行类似于ELIZA的研究。他拥有麦奎尔和洛奇为他在ELIZA上运行的脚本,并与他在UCLA的学生威廉·科恩(William Korn)一起,开始为LYRIC编写自己的脚本。

5.1加芬克尔1969年在UCLA的聊天机器人试运行

在1969年1月15日写给肯尼思·H·汤姆的一封题为“加芬克尔的申请,自然语言公式的形式结构研究”的信中,加芬克尔写道,他正在与UCLA的一组调查员合作,其中包括梅尔文·波尔纳、霍华德·施瓦茨和威廉·科恩。这封信提到了一份先前资助给空军科学研究局(AFOSR)的拨款提案(1966),据说该提案“记录”了ELIZA和LYRIC与加芬克尔和波尔纳的兴趣的关联。我们知道加芬克尔获得了“机时资金”(funds for computer time),并能够在1969年2月与科恩一起对LYRIC进行测试运行。加芬克尔档案馆中总共有15次LYRIC运行记录,这些运行可能在该提案未获资助时停止。

LYRIC的运行提供了一个诱人的预览,展示了如果拨款提案获得资助,加芬克尔可能会做些什么。从一些文字记录中可以明显看出,他/她们试图在用户和机器之间制造互动麻烦。虽然计算机程序员可能会将其描述为“故障排除”或“调试”——故意破坏代码以改进它——但加芬克尔的目标是社会学的。由于意义只能在序列中实现,在动作/话语对之间,诀窍是打破这些对子。正如在他的破坏性练习和“是-否”实验中一样,加芬克尔将互动“麻烦”视为使普通的意义构建方法可见的一种方式,即揭示参与者所导向的隐含期望/规则,在这种情况下是在人与机器之间。如果加芬克尔能让机器崩溃,他就获得了信息。

加芬克尔在“暂停:暂停符(Pause:Pausitives)”标题下进行的LYRIC运行记录

加:(登录)

LYRIC:你好。现代科学的奇迹使我们得以相互交谈,尽管我们在物理上(以及概念上)处于截然不同的处境之中。只有当你按下INT或SHIFT按钮时,你的话语才能传达给我。你为何不现在试试看呢?

加:(按下INT键)

LYRIC:很好。如果你在屏幕上看到一个小箭头,请做出一些回复。不要感到拘束。只需键入任何你觉得合适的内容,然后按下回车键(ENTER)。那么,你心里在想些什么?

加:呃……

LYRIC:请详细说明。

加:我……呃……

LYRIC:多告诉我一些关于你自己的事。

加:这个嘛……

LYRIC:我完全理解。请继续说。

加:我在想该说些什么好……

LYRIC:你怎么看这件事?

加:这正是我想要想出来的……就在……再过……一分钟……

LYRIC:你怎么看这件事?

加:嗯……

LYRIC:你一直都有这种感觉吗?

加:(暂停)……….

LYRIC:是的,那是真的,但我还是有点不清楚。

加:我知道我想说什么。(暂停)……

LYRIC:我的意见并不重要,机器停机。

“机器停机”(MACHINE DOWN)消息似乎表明程序已崩溃或自行关闭。这是加芬克尔和科恩对LYRIC进行的几次运行的结果。

在另一份日期为1969年1月的记录中,科恩通过键入披头士乐队歌曲“Happiness is a Warm Gun”的歌词来回应LYRIC的问题。最终,LYRIC回应:“我很抱歉。这很有趣,但我必须将控制权交还给我的主管。请再来看我。很高兴见到你。”

加芬克尔通过给机器制造麻烦完成了几件事。虽然他没有用这么多话告诉我们他在做什么,但他确实留下了明显的线索。一条特别有趣的线索是一张附在他与LYRIC互动打印件上的便条(1969年2月14日,试验6:3)。在记录的最后,加芬克尔写道:“备注:注意‘驯顺文本’(docile texts)的可用性与作为‘第一次线性通过’(first linear time through)的可用文本之间的区别,这是人机‘对话’的对比现象特征。”在这段简短而密集的段落中,加芬克尔区分了产生记录的“活生生的工作”(lived work)——即坐在计算机控制台前进行对话的实际操作——与事后作为结果呈现供人检查的记录对象。

完成打印为记录的与LYRIC互动的工作涉及参与其生产的所有对象的组合:键盘、终端、用户界面、用户的键入、打印机等。重要的是,它还涉及通过交换轮次和管理用户与机器之间关于轮次对的期望来实现意义的程序。然而,当互动完成并作为“驯顺文本”供检查时——即后来魏泽鲍姆等人视为用户“妄想”证据的那种文本——这种情境性及其程序就消失了。这是突出在每个特定案例中完成有意义互动的实际情况(通常称为“语境”)的工作的关键点。产生“驯顺文本”涉及理解索引性和其他与实际“活生生的工作”相关的实际偶然性的程序,加芬克尔认为,这种活生生的工作解释了人类用户报告的意义和满足感的体验。

5.2加芬克尔关于人机交互的“后台”编程工作

加芬克尔不仅关注用户界面的互动,还调查了人机交互的“后台”工作,即脚本的编程。他在会议期间与魏泽鲍姆的合作者讨论了编程问题,并在UCLA与威廉·科恩一起编写编程脚本。我们从一份报告中得知,科恩(Korn,1969)重新编写了在LYRIC上运行的脚本,作为加芬克尔课程的学生作业的一部分。虽然加芬克尔拥有麻省理工学院的ELIZA版本(带有为他编写的脚本),但科恩也使用了最初由UCLA的戴恩(Bruce M. Dane)创建的名为TALK的脚本,该脚本在许多方面类似于DOCTOR脚本。它实际上基于两个早期的设计用于进行精神分析的脚本:一个是麻省理工学院的版本叫YAP YAP,另一个是YAP YAP的副本叫COUCH。科恩(1969:5)在他的报告中描述说,戴恩像加芬克尔一样,“也有兴趣以对话方式使用该程序,而不是用于计算机辅助教学。”

加芬克尔和科恩编写了TALK的替代版本,并称之为:GABBER、PERM01和PERM02。在他的“实验材料描述”中,科恩(1969)解释说GABBER也“旨在‘做精神分析’”,并且他“进一步试图在互动中引入更多幽默”(第5页),即当用户在句子中键入“我的”时产生特定的回应(你的什么?)。这产生了相当令人困惑的对话:“这种设计之所以被认为幽默,是因为对于像‘我和我的母亲有点问题’这样的句子而言,这种回应显得非常‘荒谬’”(Korn,1969:5)。为了给互动增加进一步的外部引入的偶然性——就像在加芬克尔早期的“是-否”实验中一样——PERM01和PERM02脚本随机化了计算机操作及其对用户输入的书面回应,以便“人们无法根据GABBER的回应方式‘逻辑地预测’PERM01和PERM02将如何回应”(第6页)。加芬克尔已经在麻省理工学院对ELIZA脚本进行了实验,现在正与科恩一起探索EMCA的见解如何为计算机编程实践提供信息,并最终探索这些实践如何与人类用户的意义构建工作交织在一起。

到1973年科尔比的PARRY和ELIZA在一次国际计算机会议上的对话成名时(参见Apprich,2019),加芬克尔和科恩早在1969年就在UCLA尝试过类似的事情,尽管是以更基本的方式:他/她们使用来自ELIZA(或者更准确地说,来自DOCTOR脚本)以及COUCH的回避性输出短语作为他/她们自己实验脚本的输入。因此,加芬克尔的常人方法学研究是与当时AI最前沿的工作同时进行的。

6.索引性和“等等”对于通常被视为人机交互中“语境”的序列产生的相关性

加芬克尔利用他对ELIZA和LYRIC的研究建立在他早期的“是-否”实验和破坏性研究之上,这些研究与他考察人类参与者理解ELIZA话语的方式相辅相成。通过监测并基于人机交互的序列组织,它们构建(并不断更新)着这一局部情境,使其成为一种有意义的交换。在此过程中,他/她们揭示了通常所说的“语境问题”——或者从EMCA角度看是合作互动的序列性——实则是一种情境化的成就,并具体说明了这种成就是如何通过普通的互动意义构建实践来维持的。

加芬克尔在他与洛奇、夸顿和麦奎尔的讨论中介绍了这些论点,阐述了他在各种环境中识别出的日常、普通的意义构建实践,如“等等”、“除非”和“且过”(Garfinkel,1967),对于处理计算机控制台上的索引性与在更广泛的社会生活中一样至关重要。从这个意义上说,加芬克尔对ELIZA和LYRIC的研究突显了索引性的社会运用所占据的核心地位,无论是对于当时还是现在的AI程序,这种运用都是其实际使用和意义生成的关键。

加芬克尔对索引性的关注在他与哈维·萨克斯的合作中变得更加具体(Garfinkel and Sacks,1970)。两人都认为,将索引性表达视为需要补救的传统做法不仅是一个错误,而且是一个具有讽刺意味的错误,因为它产生了哲学家和语言学家归因于索引性的许多经久不衰的问题。根据加芬克尔的说法,“且过”是一种容纳不确定性的方式,直到在一系列轮次中实现意义识别(正如我们在ELIZA记录中看到的那样)。“等等”指的是规则需要改变并具有一定的弹性,否则无尽的漏洞和变通方法变得不可避免(另见Thielmann and Sormani,2023)。

加芬克尔指出,“无论共同理解的条款多么具体……它们只有在规定的条件带有一个未言明但被理解的‘等等’条款时,才能对人们达成协议的状态。”(Garfinkel,1967:73)这一条款不是指另一套规则、指令或命题(参考涂尔干关于社会契约非契约因素的讨论,Rawls,2021a;2021b),而是指任何互动都不可避免地伴随着并利用“无需具体说明要求即可共同知晓或可知晓”的社会生活描述和说明(Garfinkel,1962:6;另见Garfinkel et al.,1962)。这一特征为那些在序列上得以组织和维持的、有意义且可识别的行动过程奠定了条件,并“在信任规则下确立了协定”(cf. Garfinkel,1963)。

正如加芬克尔和萨克斯(1970)所论证的,“等等”和索引性在历史上一直被科学工作视为“问题”(另见Sacks,1963:10–13),而科学工作的目标正是通过明确所有操作性预设和程序规则来补救这些问题。计算理论和实践领域也是如此,它们旨在事先精确指定程序的类别和规则——这种做法试图消除一种实际上必不可少的模糊性,结果反而招致了巨大的难题(cf. Rawls and Mann,2015)。根据加芬克尔和萨克斯(1970)的说法,任何试图补救社会生活本质上的模糊性和索引性的尝试,总是且不可避免地注定会失败。

正如维特根斯坦(1953)在规则遵循问题上所展示的那样,任何规范列表都可以被无休止地进一步规定。然而,加芬克尔和萨克斯(1970)提出的关键点在于,索引性并不需要被“修复”,相反,它在互动中发挥着基础性的作用。互动中的意义构建总是依赖于那些未被谈论的事物——即那些未曾明言、却被视为理所当然的内容。也就是说,索引性和“等等”工作是意义构建的本质特征(而非某种令人讨厌的麻烦或附属品;另见Eisenmann and Rawls,2023;Button et al.,2022,Chap. 1)。此外,“等等”并非一种静态条件,而是作为互动序列组织的一个特征在运作:它“本质上与活动的内在及外在时间进程相绑定,从而也与情境及其偶然性的逐步发展相绑定”(Garfinkel,1967:73–74;另见Sacks,1992)。在互动中构建意义(以及对互动本身的理解),是与其“活生生的工作”及其时间参数——即“第一次线性通过”——反身性地联系在一起的;或者用加芬克尔(Garfinkel,2002:216)的另一种说法,是为了“每一个接下来的‘又一次’第一次”(another each next first time);它绝非作为一个已经完成的“驯顺文本”——或对此类文本的打圆场——而存在。

加芬克尔的实证发现不仅对AI的外部观察研究具有意义,而且为AI的“混合研究”(hybrid study)开辟了道路。这类研究不仅调查程序员、设计师和用户的实践,还能对编程领域本身做出贡献。关于索引性如何能为计算做出贡献的问题,在计算机科学中仍是一个未被充分探讨的话题。下面这段引文出自阿格雷(他在1980年代和1990年代与加芬克尔保持着密切联系与合作),他指出索引性是一种“语境构建的主动现象”,这一点应当为信息设计实践提供指导:

正如加芬克尔(1984[1967])会坚持认为的那样,这也是一种仅就实际目的而言“足够好”的成就;个人对于所指的“那里”“那时”或“他/她们”的精确边界可能持有不同的看法,但如果这种差异没有引起麻烦,它很可能就得过且过(pass unremarked)。对这一成就的模型论解释(如Barwise和Perry的解释),可以通过构建适当的情境来假设索引术语的潜在和实际指称对象,但它无法解释特定的人挑选出那些特定指称对象的行动。只有通过研究人们在原位(in situ)用来实现指称的实际实践,索引性才开始显现:它不仅仅是语境依赖的被动现象,而是语境构建的主动现象。(Agre,1997:233)

7.结论

魏泽鲍姆对他的ELIZA实验持批判态度,他将参与者把智能归因于机器的行为视为一种误解,甚至是妄想思维的证据,并最终主张要纠正这种后来被称为“ELIZA效应”的现象。加芬克尔则不同意这一观点。关于误解AI状态的此类论点至今仍处于讨论的中心,正如引言中讨论的谷歌LaMDA案例清楚显示的那样。这里的关键问题涉及分析师及其方法和假设,与互动中的实际参与者对于什么社会对象算作“真实”的导向之间的关系。正如1964年戈夫曼、帕森斯、罗斯、加芬克尔和萨克斯之间关于“女巫”的那场讨论所展示的一样。

EMCA的视角允许我们详细理解用户与AI互动的不同方式,以及这些互动中的意义构建是如何植根于社会实践和人类社会能力的细节之中的。在这个观点上,人们在与ELIZA互动中产生的意义不是幻觉——它们是作为这些互动的轮次结构而涌现和存在的社会对象。非常人方法学家可能会问:在缺乏“真正的人-人互惠”的情况下,受试者如何设法构建意义?但是,对于加芬克尔来说,这个问题恰恰预设了它本该去考察的内容。人类参与者无法“读取”其他参与者的思想,无论对方是机器、人还是灵魂。关于“人类能动性”(human agency)的假设,以及认为存在“真正的”思想互惠的想法是错误的,这会将人们引入歧途。加芬克尔追问的是,人与人(或人与机器)之间的互动是否展现出了某种可识别的秩序属性,以供参与者用来构建意义。如果它确实表现出这种秩序属性,并且它们可以以参与者能够理解的方式符合构成性期望,那么意义就已经实现了。

用户假定信任条件,并以其对这些条件的义务为导向,直到出现麻烦。麻烦可能来自互动的人类一端,也可能来自机器。但是,只要机器没有明显表现出它有预先编码的脚本以及它没有导向信任条件,人类的规则就是假定信任条件存在,意义构建将继续进行,直到失败。正如在“随机是-否回答”实验中一样,用户通过将ELIZA的行为视为有动机的行为——即由前一个轮次的行动所激发的,并作为连贯的轮次序列的一部分(由信任条件涵盖)——就像对待他/她们自己的人类反应一样——以通常的方式理解ELIZA的行为。加芬克尔(1967:94;2019[1959]:26)对“是-否实验”的描述同样适用于ELIZA/LYRIC与其人类用户的互动以及更多情况:

“通过以此证彼(documenting)的工作——即通过搜寻和确定模式,通过将顾问的回答视为由问题的预期意义所激发,通过等待后来的回答来澄清先前回答的意义,通过为未问的问题寻找答案……所建议内容的感知正常值(perceivedly normal values)被建立、测试、审查、保留、恢复;总之,被管理。”

简而言之,人类用户在与机器通信时,进行着他/她们普通的意义构建互动工作,正是这创造了他/她们体验到的意义。

加芬克尔对人机交互的实验记录了机器对人类意义构建承诺的依赖。他的破坏性脚本(如果我们能这样称呼它们的话)旨在制造麻烦,以揭示情境如何在打字用户与机器(包括其界面、编程和物理组件的整体)之间的互动中产生。它还展示了人类用户如何在面对麻烦时仍致力于理解互动序列,并且在这样做时,证明了AI系统在本质上有赖于用户的意义构建工作才能有效运行。因此,加芬克尔的早期研究揭示了处于媒体和技术核心的合作实践(Schüttpelz,2023),允许我们根据其人类用户的构成性社会实践——即这些现象通常被产生和变得可识别的方法——来重新描述(respecify)诸如“ELIZA效应”“确认偏误”和“认知失调”等事物(cf. Rawls and Turowetz,2021;Turowetz and Rawls,2021)。

自加芬克尔的开创性工作以来的几十年里,基于EMCA的研究一直专注于AI和社会行动的概念问题(例如Button et al.,1995;Gilbert and Heath,1985;Suchman,1993),同时也考察了EMCA发现如何应用于计算机对话系统的开发(例如McIlvenny,1990;Raudaskoski,1990;Thomas,1991;Wooffitt,1994)。最近,随着基于AI的设备在日常生活中变得根深蒂固,EMCA研究人员正在对机器人、语音用户界面(VUI)和具身类人代理进行研究。这项研究详细记录了人们在与机器互动时如何调整自己的行为,例如与所谓的“对话代理”互动。波尔舍龙(Porcheron et al.,2018)认为参与者与语音用户界面的对话是基于“输入”和“输出”而不是“对话”(另见Reeves and Porcheron,2022)。另一方面,即使是简单的技术系统也能产生可识别的有意义的交换(Relieu et al.,2020),正如科尔布特(Korbut,2023)所认为的那样,在某些场景中,用户将聊天机器人视为对话伙伴。伊瓦尔松和林德沃尔(2023)表明,对正在进行的谈话的序列和分类分析是将“智能”归因于机器的基础。

我们在本文中指出,加芬克尔对ELIZA和LYRIC的研究已过去多年,但它仍可以为当下的AI互动研究提供重要启示。虽然目前的许多AI系统仍植根于认知主义和个人主义的心智模型,但它们通常被用于彻底的社会场景中。关于“能力”或“能动性”的问题并不位于机器内部,而是位于人类意义构建的合作实现秩序中。

EMCA方法也为AI研究人员和程序员研究和贡献设计与软件开发开辟了途径。在理论基础和技术开发方面(例如,见Alač,2009;Brooker and Mair,2022;Gehle et al.,2017;Krummheuer,2015;Mair et al.,2020;Pelikan et al.,2020;Saha et al.,2023),这些途径正在被进一步探索。在他对计算的开创性研究中,阿格雷(1997)证明了程序员的工作如何在很大程度上已经依赖于日常理解以及心灵的哲学理论,但这种依赖在很大程度上仍然是默会的。这些默会假设在EMCA中被重新界定为实证调查的主题。阿格雷和他的同事(包括戴维·查普曼)认为,AI开发在1980年代末和1990年代遇到了瓶颈。加芬克尔对ELIZA/LYRIC的研究,使我们得以重新界定类别、信息对象和计算等核心概念;它同时也呼吁一种更严肃对待索引性与序列性之必要性的研究进路,将这种进路应用于当代AI计算,或许恰好能解决阿格雷等人所指出的那些难题。

本文原载于《人工智能与社会》(AI & Society)杂志,原题为《机器停机:理解人机交互——加芬克尔1967年至1969年对ELIZA和LYRIC的研究及其当代意义》(Machine down: Understanding human–machine interaction – Garfinkel's research on ELIZA and LYRIC 1967–1969 and its contemporary relevance)。文章得到德国研究基金会(DFG)资助(项目ID:SFB 1187)。有关作者在人机交互、常人方法学等领域的更多研究,可参考作者学术主页。感谢作者Clemens Eisenmann、Jakub Mlynář、Jason Turowetz、Anne W. Rawls授权翻译。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2026 上海东方报业有限公司